爱芯通元NPU完成Llama 3和Phi-3大模型适配,推动AI大模型技术应用普及

中国 2024年04月28日——人工智能芯片研发及基础算力平台公司爱芯元智宣布,近日,Meta、Microsoft相继发布具有里程碑意义的Llama 3系列和Phi-3系列模型。为了进一步给开发者提供更多尝鲜,爱芯元智的NPU工具链团队迅速响应,已基于AX650N平台完成 Llama 3 8B和Phi-3-mini模型适配。

Llama 3

上周五,Meta发布了Meta Llama 3系列语言模型(LLM),具体包括一个8B模型和一个70B模型在测试基准中,Llama 3模型的表现相当出色,在实用性和安全性评估中,与那些市面上流行的闭源模型不相上下。

官方网址:https://llama.meta.com/llama3

在架构层面,Llama 3选择了标准的仅解码(decoder-only)式Transformer架构,采用包含128K token词汇表的分词器。Llama 3使用了超过15T的公开数据进行训练,其中5%为非英文数据,涵盖30多种语言,训练数据量是前代Llama 2的七倍。

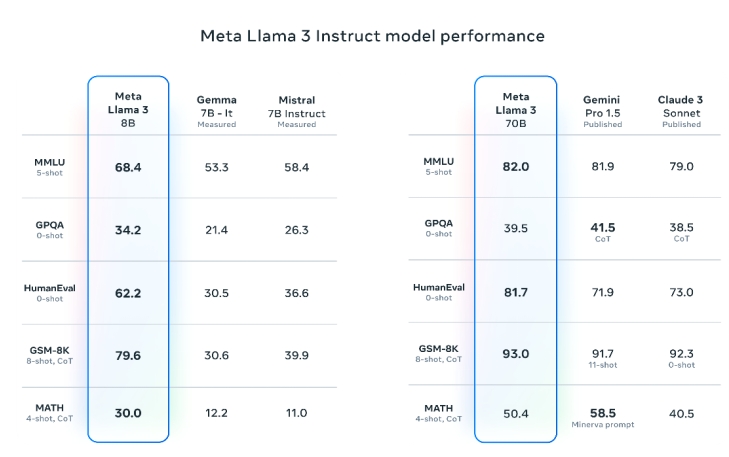

根据Meta的测试结果,Llama 3 8B模型在MMLU、GPQA、HumanEval等多项性能基准上均超过了Gemma 7B和Mistral 7B Instruct,70B模型则超越了名声在外的闭源模型Claude 3的中间版本Sonnet,和谷歌的Gemini Pro 1.5相比三胜两负。

实际上板结果:目前AX650N已经完成了Llama 3 8B Int8版本的适配,若采用Int4量化,每秒token数还能再翻一倍,能满足正常的人机交流。

Phi-3

Llama 3刚发布没多久,竞争对手就来了,而且是可以在手机上运行的小体量模型。

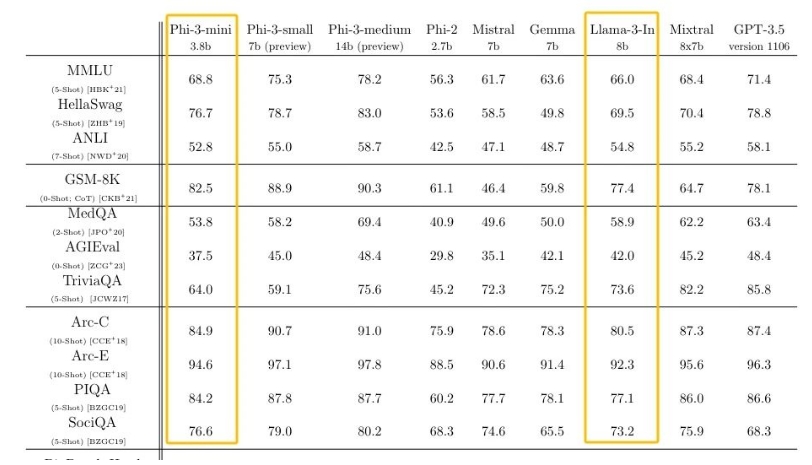

本周二,微软发布了自研小尺寸模型Phi-3。尽管Phi-3-mini被优化至可部署在手机上,但它的性能可以与Mixtral 8x7B和GPT-3.5等模型相媲美。微软表示,该创新主要在于用了质量更好的训练数据集。

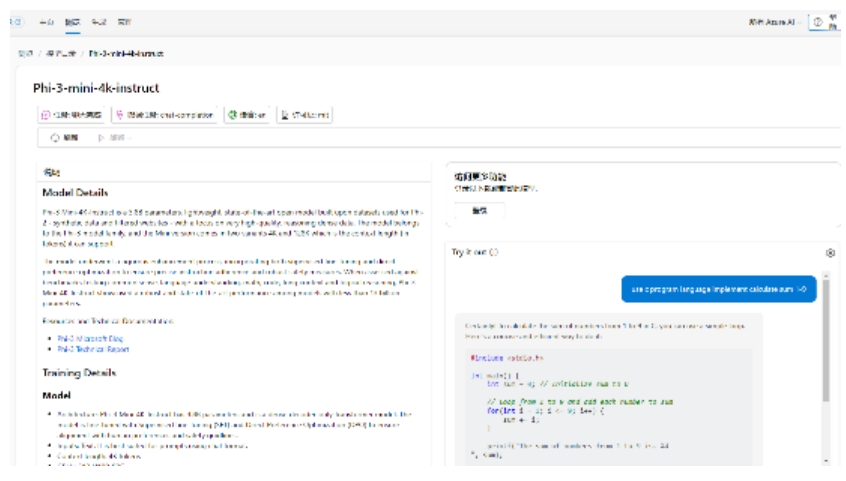

在线DEMO:https://ai.azure.com/explore/models/Phi-3-mini-4k-instruct/version/2/registry/azureml

实际上板结果:目前AX650N已经完成了Phi-3-mini Int8版本的适配,已能满足正常的人机交流。

其他成果

AX650N能第一时间完成Llama 3和Phi-3的适配,源于今年以来相关团队悄悄完成了现有NPU工具链针对大语言模型的支持和调优。目前除了Llama 3之外,已经完成了Llama 2、TinyLlama、Phi-2、Qwen1.5、ChatGLM3等国内外主流的开源大语言模型适配。

相关成果已释放到开发者社区(https://github.com/AXERA-TECH/ax-llm)欢迎尝鲜。

后续计划

今年是AIPC的元年,爱芯元智将针对AIPC的常见应用提供更多的解决方案。充分发挥爱芯通元NPU高能效比的技术优势,让各种有趣的大模型实现高性价本地化部署,做到“人人都用得起大模型”,深入实践“普惠AI,造就美好生活”。

关于爱芯元智:

爱芯元智半导体股份有限公司成立于2019年5月,致力于打造世界领先的人工智能感知与边缘计算芯片,服务智慧城市、智能驾驶、机器人以及AR/VR等巨大的边缘和端侧设备市场。公司自研两大核心技术——爱芯智眸AI-ISP和爱芯通元混合精度NPU,在过去的四年时间里,完成了四代多颗智能芯片产品的研发和量产工作。爱芯元智秉承“普惠AI,造就美好生活”的使命,以“构建世界一流的感知与计算平台”为愿景,致力于成为物理世界数字化入口,为不同行业提供人工智能的基础算力平台,使智能真正触手可及。

- •2026最硬科技!原子级3D成像揭示芯片内部“鼠咬”缺陷,芯片研发从此不同2026-03-06

- •以创新驱动能效:Melexis推出全新“保护器件”系列,开启功率电子新篇章2026-03-06

- •芯片战再升级!美政府采购禁令来袭,SIA强烈发声反对2026-03-05

- •ROHM发布搭载新型SiC模块的三相逆变器参考设计!2026-03-05

- •为800V应用选择合适的半导体技术2026-03-05

- •Qorvo荣获建兴储存科技公司“供应商冠军奖”2026-03-05

- •美光科技携手印度,打造全球记忆芯片新枢纽!Sanand工厂正式投产,全球供应链加速重塑2026-03-04

- •瑞萨电子推出28纳米RH850/U2C汽车微控制器, 拓展面向车辆控制与汽车安全应用领域的产品阵容2026-03-04

- •罗姆加强GaN功率器件供应能力2026-03-02

- •瑞萨电子强化高层管理, 推进印度与中国市场战略布局2026-03-02