AI加速器竞争白热化 NVIDIA捍卫江山有筹码

随着人工智能(AI)服务器GPU加速器需求转热,越来越多大厂投入市场,不禁令人好奇,面对新对手接连进逼,一直处于领先地位的NVIDIA如何捍卫江山,未来是否有筹码还击。

当市场需求攀升,少数供应商得到丰厚的获利时,更多的厂商即会相继投入抢食大饼,这是基本的经济运作。在AI加速器市场亦然,NVIDIA早期跨入此领域,拜企业和云端服务业者AI相关投资与日具增之赐,NVIDIA的Tesla GPU需求畅旺,公司业绩也大进补。

以2017年上半为例,NVIDIA首季数据中心产品销售激增逾2倍,第2季续增186%。NVIDIA在AI领域耀眼的表现引起其他科技大厂的注意,过去1年来包括英特尔(Intel)、超微(AMD)、富士通(Fujitsu)和Alphabet相继推出AI服务器加速器,或宣布准备进军市场。

随着市场竞争逐渐白热化,NVIDIA该如何维持竞争优势?这可以从比较NVIDIA的GPU和对手产品找到答案。服务器CPU与PC和移动CPU一样,仅能容纳少量相对强而有力的CPU核心,例如最强而有力的英特尔Xeon Scalable服务器CPU有28核。反观GPU可以有上千个小核心并行运作。也因此,对于不断地进行演算和推论的AI深度学习训练而言,GPU比CPU更适合。

推论演算法不一定要求巨大的处理能力,GPU就可以应付这些任务,有鉴于此,NVIDIA试着让GPU在此获得更多的采用。不过,许多服务器端的推论工作仍然以英特尔的Xeon CPU为主。苹果(Apple)因隐私权的关系,偏好直接在iOS装置以AI演算法处理用户数据。

然而,训练深度学习模型来创造演算法解读数据,例如自动驾驶系统翻译简讯或侦测交通号志等都需要密集的运算,训练过程中,数千甚至数百万个人工神经元化分成许多“层”(layer,如输入层、隐藏层、输出层等)来负责不同的任务,以及和其他层的神经元沟通,以便判断数据分析后的结果是否无误,例如输入的影像是否为停车标志(stop sign)等。

比起不到30核心的CPU,AI研究人员利用多个拥有数千个核心的Tesla GPU来分担人工神经元的工作,训练深度学习模型将加快许多。深度学习演算是一种复杂的数学,而这正是NVIDIA的Tesla GPU擅长的领域,它还可以提供一个具有众多存储器频宽的模型,以及高速连结芯片来进行沟通。

但这并不意味着GPU是唯一适合训练深度学习模型的处理器,理论上芯片制造厂也可以开发一个配备数千个核心,专为处理深度学习演算而设计的特殊应用积体电路(ASIC),让它们能与存储器或其他ASIC快速沟通。

英特尔似乎有这样的想法,2016年收购Nervana Systems取得必要的技术和人才后,着手打造深度学习ASIC“Lake Crest”。英特尔号称Lake Crest的并行处理能力是前所未见的水准,原始运算能力比当前最先进的GPU(显然指的是NVIDIA)还强。此外,Lake Crest还可支援每秒1兆位元(TB)的存储器频宽,连结速度比标准PCI Express快20倍。

Lake Crest将于年底问世,英特尔同时也准备推出Knights Crest,此为整合Nervana技术的Xeon Phi协同处理器其中的一个版本。Xeon Phi芯片应用于较不复杂的AI专案,以及高速运算(high-performance computing;HPC)工作负载上。

Google最近发表第二代Tensor Processing Unit(TPU),第一代TPU仅有推论能力,新的TPU则可训练深度学习模型。Google宣称TPU模组在特定的深度学习运作中,可以达到每秒180兆次的浮点运算(teraflop),比NVIDIA最近发表的Tesla V100旗舰服务器GPU的120 teraflop还快。不过,TPU仅能与Google的TensorFlow软件架构并用,而且Google不打算销售TPU,只用于公司内部AI开发,以及让云端客户使用。

其他大厂如AMD最近推出Radeon Instinct服务器GPU,其中最强的M125是不错的产品,但以原始效能来看仍落后V100,特别是64-bit运算时,而且存储器频宽也比较少,目前显然不至于对Tesla GPU构成威胁。此外,富士通最近也宣布要在2018年会计年度发布一个ASIC深度学习处理器。

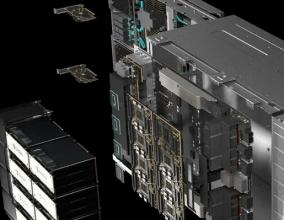

不过,尽管新对手来势汹汹,NVIDIA拥有强有力的武器来予以迎击。其中之一是庞大的GPU研发支出,NVIDIA主要用于打造新的GPU架构,特别是深度学习的GPU。例如Tesla V100采用新的Volta GPU架构,同时使用了5,120个传统的CUDA GPU核心和640个tensor核心作为深度学习训练之用。

但就长期而言,NVIDIA最大的竞争优势或许起步比别人早,围绕着Tesla GPU的AI生态系统已经成形。现在开发者逐渐习惯使用NVIDIA的CUDA GPU应用程式介面(API),以及深度软件开发套件的各种工具,包括cuDNN软件图书馆等。

NVIDIA的生态系统也吸引其他科技巨擘的参与,4月NVIDIA和Facebook宣布共同合作,为Tesla GPU提升Facebook的Caffe2 AI软件架构。不久之后,微软(Micorsoft)也宣布,该公司新版SQL服务器数据库将可与Tesla GPU一起运作处理深度学习的工作。

关注电子行业精彩资讯,关注华强资讯官方微信,精华内容抢鲜读,还有机会获赠全年杂志

关注方法:添加好友→搜索“华强微电子”→关注

或微信“扫一扫”二维码

- •Cadence 利用 NVIDIA Grace Blackwell 加速 AI 驱动的工程设计和科学应用2025-03-24

- •MathWorks 与 NVIDIA 联手加速医疗技术领域中软件定义工作流的开发2024-05-08

- •Arm 推出新一代 Ethos-U AI 加速器及全新物联网参考设计平台,加速推进边缘 AI 发展…2024-04-09

- •24万元一片!NVIDIA最强GPU全面投产,超 50 款服务器型号面世2022-09-22

- •英伟达暂停对俄罗斯进行销售2022-03-07

- •凌华科技推出业内首款基于NVIDIA Turing架构的MXM图形模块2021-05-11

- •Imagination终极AI加速器为ADAS和自动驾驶提供颠覆行业的性能2020-11-13

- •NVIDIA宣布50多款安培服务器:史上最大飞跃2020-06-23

- •杯弓蛇影!“无限追溯”若一语成谶,半导体国家队有多少替代筹码?2020-05-13

- •Intel、AMD、NVIDIA集体退出台北电脑展2020-05-11