Nvidia发表超大规模推论平台,瞄准大规模AI推论应用需求

Nvidia推出用于语音、影片、图片以及推荐服务的Tensorrt超大规模推论平台(Tensorrt Hyperscale Inference Platform),其使用的Tesla GPU提供高速处理深度学习工作负载的能力,而推论优化引擎TensorRT则可以充分利用Tesla GPU的效能,处理影片串流、语音和推荐系统等应用,并为Nvidia DeepStream SDK提供运算基础。

Nvidia提到,现在大规模数据中心可以借助超大规模推论平台的能力,使用增强的自然语言互动,并直接获取查询的答案,而非只是一些预存的可能候选答案。

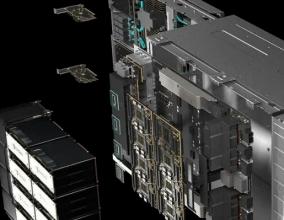

超大规模推论平台由三个主要部分组成,Tesla T4 GPU、TensorRT 5以及TensorRT推论服务器。 Tesla T4 GPU拥有320个Turing Tensor Cores以及2,560个CUDA核心,提供灵活的FP32、FP16、INT8和INT4的多精度运算,其推测速度是相同耗能CPU的40倍。

而TensorRT 5则是推论优化程序和Runtime引擎,TensorRT 5支持Turing Tensor Core,针对多精度工作负载扩展了神经网络优化,能低延迟提供推荐系统、语音识别和机器翻译等高吞吐量的应用服务, 并且TensorRT还能将使用32或是16位数据训练的模型,为Tesla T4和P4上优化成INT8操作,以及在Tesla V100上优化为FP16。 同时还赋予DeepStream SDK利用Tesla GPU,同时译码和分析影片串流。

TensorRT推论服务器是容器化的微服务软件,可以在数据中心环境让应用程序使用人工智能模型。 TensorRT推测服务器是一个可以立即执行的容器,其提供的微服务可以让用户透过API,在一个或是多个GPU上,使用Caffe2、TensorRT和TensorFlow等任何支持ONNX标准的框架进行推测。

关注电子行业精彩资讯,关注华强资讯官方微信,精华内容抢鲜读,还有机会获赠全年杂志

关注方法:添加好友→搜索“华强微电子”→关注

或微信“扫一扫”二维码

- •突发!AMD和Nvidia或断供中国高端GPU,已收到通知2022-09-01

- •Nvidia下一代GPU将采用三星7nm工艺2019-06-11

- •挑战Nvidia与超微 首款英特尔独显预定在2020年出货2018-06-14

- •Nvidia宣布:显卡终于跌回原价 库存充足2018-05-11

- •预期Volta架构绘图芯片需求成长,华尔街普遍看好Nvidia2017-11-14

- •Nvidia擅于训练,Xilinx和Intel长于推断,谁会成为AI芯片大赢家?2017-09-19

- •Nvidia首次投资中国企业,这家自动驾驶初创公司凭啥获得青睐?2017-08-04

- •三星增产8GB HBM2显存 NVIDIA受益2017-07-18

- •深度剖析AMD产品战略,能赶上Nvidia和Intel吗?2017-07-04

- •人工智能风口,英伟达GPU已成不可或缺的工具2017-06-28